“딸 목소리 똑같은데”…인공지능 ‘딥보이스’ 악용한 사기까지'

입력 2024.07.25 (21:41)

수정 2024.07.25 (22:11)

읽어주기 기능은 크롬기반의

브라우저에서만 사용하실 수 있습니다.

[앵커]

KBS전주방송총국이 마련한 연중기획 순서입니다.

전화금융사기 범죄가 인공지능 기술을 활용해 갈수록 진화하고 있습니다.

전화기 너머에서 가족이나 친구 목소리로 돈을 보내달라는데, 그 목소리가 가짜라면 어떻게 하실 건가요?

서윤덕 기자가 취재했습니다.

[리포트]

한 여성이 은행 창구에 앉아 있습니다.

"친구 보증을 섰다 잡혀 왔다"는 딸의 전화를 받고 황급히 2천만 원을 찾으러 온 어머니입니다.

전화금융사기로 판단한 은행 창구 직원 덕에 피해로 이어지지는 않았지만, 음색과 말투가 딸과 거의 비슷했다는 어머니 말에, 당시 경찰은 인공지능 기술 악용 가능성을 제기했습니다.

[경찰 관계자/음성변조 : "피해자 말을 들으니까 '딸의 음성하고 비슷하다'고 이야기하니까…. '음성 복제' 기술이 사용되지 않았을까…."]

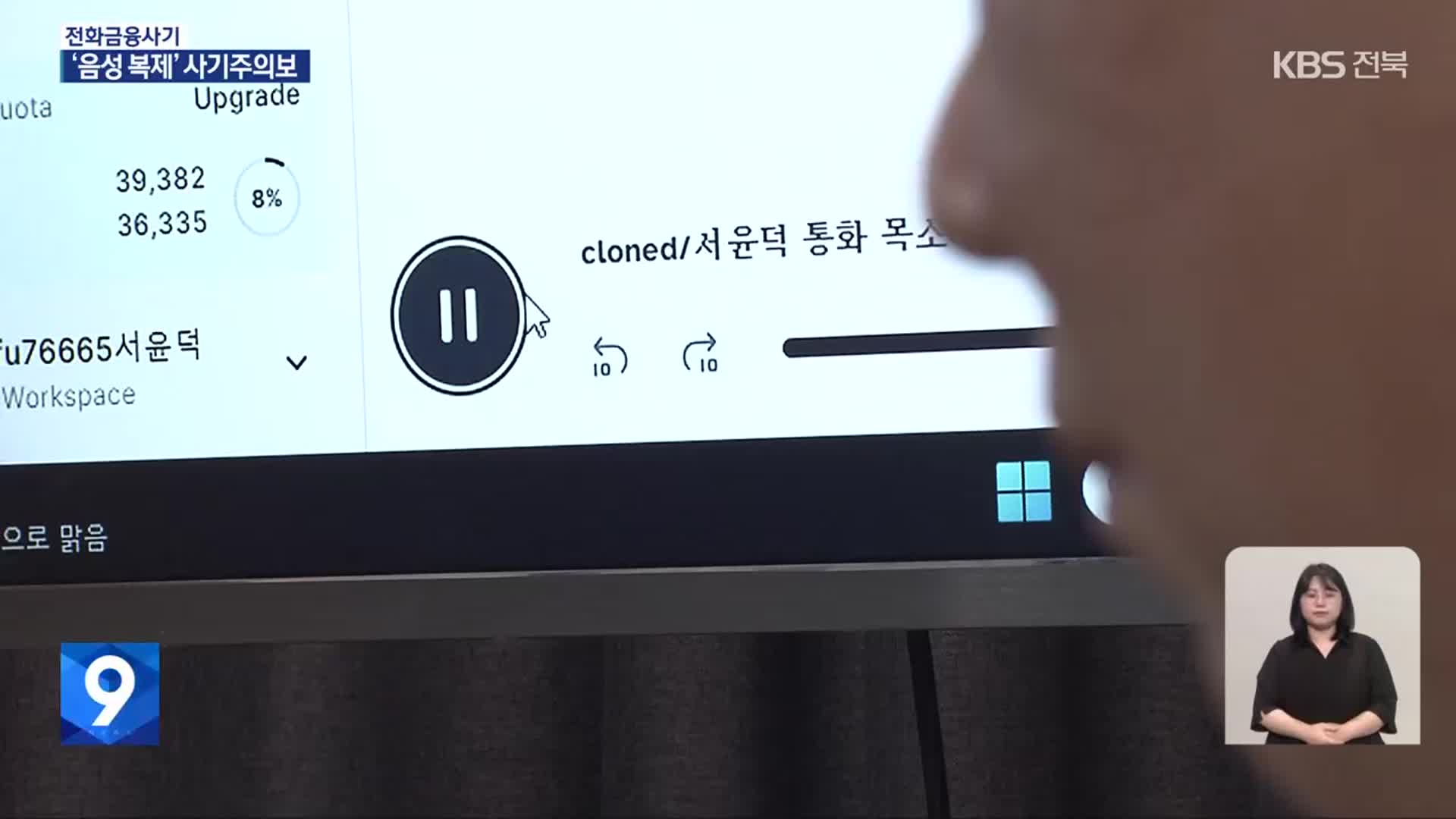

짧은 길이의 음성 표본만으로도 누구나 인공지능 기술을 이용해 그 사람이 말하는 것처럼 꾸며낼 수 있습니다.

인공지능으로 만든 목소리가 실제 제 목소리와 얼마나 비슷한지 동료 기자들에게 전화를 걸어 실험해봤습니다.

금전과 전혀 관계없이 일상적인 대화만으로 이뤄진 20초 남짓 녹음 파일을 기반으로 돈을 빌려달라는 음성 문장을 만들었습니다.

[동료 기자 : "여보세요?"]

[인공지능 음성 : "형. 진짜 미안한데 급해서 그런데 10만 원만 빌려줘라."]

[동료 기자 : "응. 뭐. 보내주면 돼?"]

곧바로 돈을 이체하겠다고 말합니다.

[서윤덕/기자 : "인공지능으로 목소리 만들어서 실험하고 있거든요."]

[동료 기자 : "네 목소리 똑같다."]

설사 속지 않더라도 아는 사람과 목소리나 말투가 거의 비슷하다 보니 께름칙한 기분을 지울 수가 없습니다

여기에 얼굴 등 이미지를 본 따는 딥페이크 기술까지 병행하면 누구든 감쪽같이 속을 수밖에 없습니다.

이렇다 보니, 전문가들은 가족이나 지인을 사칭하는 전화금융사기에 악용할 가능성이 크다고 경고합니다.

[박종승/전주대학교 경찰학과 교수 : "'아이가 납치됐다'라거나 이런 경우에 이제 사용될 수가 있겠죠. 동일한 목소리, 자식의 얼굴까지 이렇게 충분히 이용할 수 있는 범죄이다 보니까…."]

전문가들은 음성 복제가 의심될 경우, 일단 아무 말 없이 끊어야 하고, 가족이나 지인끼리 미리 암호를 정하는 것도 피해 예방에 도움 된다고 당부합니다.

KBS 뉴스 서윤덕입니다.

촬영기자:정성수

KBS전주방송총국이 마련한 연중기획 순서입니다.

전화금융사기 범죄가 인공지능 기술을 활용해 갈수록 진화하고 있습니다.

전화기 너머에서 가족이나 친구 목소리로 돈을 보내달라는데, 그 목소리가 가짜라면 어떻게 하실 건가요?

서윤덕 기자가 취재했습니다.

[리포트]

한 여성이 은행 창구에 앉아 있습니다.

"친구 보증을 섰다 잡혀 왔다"는 딸의 전화를 받고 황급히 2천만 원을 찾으러 온 어머니입니다.

전화금융사기로 판단한 은행 창구 직원 덕에 피해로 이어지지는 않았지만, 음색과 말투가 딸과 거의 비슷했다는 어머니 말에, 당시 경찰은 인공지능 기술 악용 가능성을 제기했습니다.

[경찰 관계자/음성변조 : "피해자 말을 들으니까 '딸의 음성하고 비슷하다'고 이야기하니까…. '음성 복제' 기술이 사용되지 않았을까…."]

짧은 길이의 음성 표본만으로도 누구나 인공지능 기술을 이용해 그 사람이 말하는 것처럼 꾸며낼 수 있습니다.

인공지능으로 만든 목소리가 실제 제 목소리와 얼마나 비슷한지 동료 기자들에게 전화를 걸어 실험해봤습니다.

금전과 전혀 관계없이 일상적인 대화만으로 이뤄진 20초 남짓 녹음 파일을 기반으로 돈을 빌려달라는 음성 문장을 만들었습니다.

[동료 기자 : "여보세요?"]

[인공지능 음성 : "형. 진짜 미안한데 급해서 그런데 10만 원만 빌려줘라."]

[동료 기자 : "응. 뭐. 보내주면 돼?"]

곧바로 돈을 이체하겠다고 말합니다.

[서윤덕/기자 : "인공지능으로 목소리 만들어서 실험하고 있거든요."]

[동료 기자 : "네 목소리 똑같다."]

설사 속지 않더라도 아는 사람과 목소리나 말투가 거의 비슷하다 보니 께름칙한 기분을 지울 수가 없습니다

여기에 얼굴 등 이미지를 본 따는 딥페이크 기술까지 병행하면 누구든 감쪽같이 속을 수밖에 없습니다.

이렇다 보니, 전문가들은 가족이나 지인을 사칭하는 전화금융사기에 악용할 가능성이 크다고 경고합니다.

[박종승/전주대학교 경찰학과 교수 : "'아이가 납치됐다'라거나 이런 경우에 이제 사용될 수가 있겠죠. 동일한 목소리, 자식의 얼굴까지 이렇게 충분히 이용할 수 있는 범죄이다 보니까…."]

전문가들은 음성 복제가 의심될 경우, 일단 아무 말 없이 끊어야 하고, 가족이나 지인끼리 미리 암호를 정하는 것도 피해 예방에 도움 된다고 당부합니다.

KBS 뉴스 서윤덕입니다.

촬영기자:정성수

■ 제보하기

▷ 카카오톡 : 'KBS제보' 검색, 채널 추가

▷ 전화 : 02-781-1234, 4444

▷ 이메일 : kbs1234@kbs.co.kr

▷ 유튜브, 네이버, 카카오에서도 KBS뉴스를 구독해주세요!

- “딸 목소리 똑같은데”…인공지능 ‘딥보이스’ 악용한 사기까지'

-

- 입력 2024-07-25 21:41:21

- 수정2024-07-25 22:11:31

[앵커]

KBS전주방송총국이 마련한 연중기획 순서입니다.

전화금융사기 범죄가 인공지능 기술을 활용해 갈수록 진화하고 있습니다.

전화기 너머에서 가족이나 친구 목소리로 돈을 보내달라는데, 그 목소리가 가짜라면 어떻게 하실 건가요?

서윤덕 기자가 취재했습니다.

[리포트]

한 여성이 은행 창구에 앉아 있습니다.

"친구 보증을 섰다 잡혀 왔다"는 딸의 전화를 받고 황급히 2천만 원을 찾으러 온 어머니입니다.

전화금융사기로 판단한 은행 창구 직원 덕에 피해로 이어지지는 않았지만, 음색과 말투가 딸과 거의 비슷했다는 어머니 말에, 당시 경찰은 인공지능 기술 악용 가능성을 제기했습니다.

[경찰 관계자/음성변조 : "피해자 말을 들으니까 '딸의 음성하고 비슷하다'고 이야기하니까…. '음성 복제' 기술이 사용되지 않았을까…."]

짧은 길이의 음성 표본만으로도 누구나 인공지능 기술을 이용해 그 사람이 말하는 것처럼 꾸며낼 수 있습니다.

인공지능으로 만든 목소리가 실제 제 목소리와 얼마나 비슷한지 동료 기자들에게 전화를 걸어 실험해봤습니다.

금전과 전혀 관계없이 일상적인 대화만으로 이뤄진 20초 남짓 녹음 파일을 기반으로 돈을 빌려달라는 음성 문장을 만들었습니다.

[동료 기자 : "여보세요?"]

[인공지능 음성 : "형. 진짜 미안한데 급해서 그런데 10만 원만 빌려줘라."]

[동료 기자 : "응. 뭐. 보내주면 돼?"]

곧바로 돈을 이체하겠다고 말합니다.

[서윤덕/기자 : "인공지능으로 목소리 만들어서 실험하고 있거든요."]

[동료 기자 : "네 목소리 똑같다."]

설사 속지 않더라도 아는 사람과 목소리나 말투가 거의 비슷하다 보니 께름칙한 기분을 지울 수가 없습니다

여기에 얼굴 등 이미지를 본 따는 딥페이크 기술까지 병행하면 누구든 감쪽같이 속을 수밖에 없습니다.

이렇다 보니, 전문가들은 가족이나 지인을 사칭하는 전화금융사기에 악용할 가능성이 크다고 경고합니다.

[박종승/전주대학교 경찰학과 교수 : "'아이가 납치됐다'라거나 이런 경우에 이제 사용될 수가 있겠죠. 동일한 목소리, 자식의 얼굴까지 이렇게 충분히 이용할 수 있는 범죄이다 보니까…."]

전문가들은 음성 복제가 의심될 경우, 일단 아무 말 없이 끊어야 하고, 가족이나 지인끼리 미리 암호를 정하는 것도 피해 예방에 도움 된다고 당부합니다.

KBS 뉴스 서윤덕입니다.

촬영기자:정성수

KBS전주방송총국이 마련한 연중기획 순서입니다.

전화금융사기 범죄가 인공지능 기술을 활용해 갈수록 진화하고 있습니다.

전화기 너머에서 가족이나 친구 목소리로 돈을 보내달라는데, 그 목소리가 가짜라면 어떻게 하실 건가요?

서윤덕 기자가 취재했습니다.

[리포트]

한 여성이 은행 창구에 앉아 있습니다.

"친구 보증을 섰다 잡혀 왔다"는 딸의 전화를 받고 황급히 2천만 원을 찾으러 온 어머니입니다.

전화금융사기로 판단한 은행 창구 직원 덕에 피해로 이어지지는 않았지만, 음색과 말투가 딸과 거의 비슷했다는 어머니 말에, 당시 경찰은 인공지능 기술 악용 가능성을 제기했습니다.

[경찰 관계자/음성변조 : "피해자 말을 들으니까 '딸의 음성하고 비슷하다'고 이야기하니까…. '음성 복제' 기술이 사용되지 않았을까…."]

짧은 길이의 음성 표본만으로도 누구나 인공지능 기술을 이용해 그 사람이 말하는 것처럼 꾸며낼 수 있습니다.

인공지능으로 만든 목소리가 실제 제 목소리와 얼마나 비슷한지 동료 기자들에게 전화를 걸어 실험해봤습니다.

금전과 전혀 관계없이 일상적인 대화만으로 이뤄진 20초 남짓 녹음 파일을 기반으로 돈을 빌려달라는 음성 문장을 만들었습니다.

[동료 기자 : "여보세요?"]

[인공지능 음성 : "형. 진짜 미안한데 급해서 그런데 10만 원만 빌려줘라."]

[동료 기자 : "응. 뭐. 보내주면 돼?"]

곧바로 돈을 이체하겠다고 말합니다.

[서윤덕/기자 : "인공지능으로 목소리 만들어서 실험하고 있거든요."]

[동료 기자 : "네 목소리 똑같다."]

설사 속지 않더라도 아는 사람과 목소리나 말투가 거의 비슷하다 보니 께름칙한 기분을 지울 수가 없습니다

여기에 얼굴 등 이미지를 본 따는 딥페이크 기술까지 병행하면 누구든 감쪽같이 속을 수밖에 없습니다.

이렇다 보니, 전문가들은 가족이나 지인을 사칭하는 전화금융사기에 악용할 가능성이 크다고 경고합니다.

[박종승/전주대학교 경찰학과 교수 : "'아이가 납치됐다'라거나 이런 경우에 이제 사용될 수가 있겠죠. 동일한 목소리, 자식의 얼굴까지 이렇게 충분히 이용할 수 있는 범죄이다 보니까…."]

전문가들은 음성 복제가 의심될 경우, 일단 아무 말 없이 끊어야 하고, 가족이나 지인끼리 미리 암호를 정하는 것도 피해 예방에 도움 된다고 당부합니다.

KBS 뉴스 서윤덕입니다.

촬영기자:정성수

-

-

서윤덕 기자 duck@kbs.co.kr

서윤덕 기자의 기사 모음

-

이 기사가 좋으셨다면

-

좋아요

0

-

응원해요

0

-

후속 원해요

0

![[단독] LG 그룹 맏딸 ‘주식 취득’ 증선위 심판대로…“미공개 정보 이용 정황 확인”](/data/news/2024/09/27/20240927_doETbx.jpg)

이 기사에 대한 의견을 남겨주세요.