“챗GPT야! 개인정보 수집 가능해?”…내 개인정보가 위험하다 [탈탈털털]

입력 2025.02.25 (10:02)

수정 2025.02.25 (10:07)

읽어주기 기능은 크롬기반의

브라우저에서만 사용하실 수 있습니다.

요약

KBS는 정부와 민간의 다양한 사이버 보안 현황을 점검하고, 사이버 영토에서 안전한 대한민국을 만들고자 연중기획 [탈탈털털]을 통해 공개합니다. 한 번 털리면 또 '털'리고 두 번도 '털'리는 게 사이버 범죄입니다.

그래서 디지털 기사 시리즈 제목이 [탈탈털털]이 됐습니다.

■ 챗GPT에서 '편법' 없이도 개인정보 수집 가능?

챗GPT는 기본적으로 웹 기반 검색을 통해 이용자들에게 적절한 답변을 찾아주고 있습니다.

덕분에 우리는 일일이 검색하지 않아도 입력값만 주면 웬만한 정보는 한꺼번에 볼 수 있습니다.

편리해진 만큼, 악용 우려도 커지고 있습니다.

카이스트 신승원 교수 연구팀이 자체적인 방법 기법이나 기준이 있지만 우회하며 사이버 공격이 가능하다고 밝혔는데요, "웹 검색 LLM을 활용한 개인정보 기반 사이버공격"이라는 제목의 논문에서 자세하게 설명하고 있습니다.

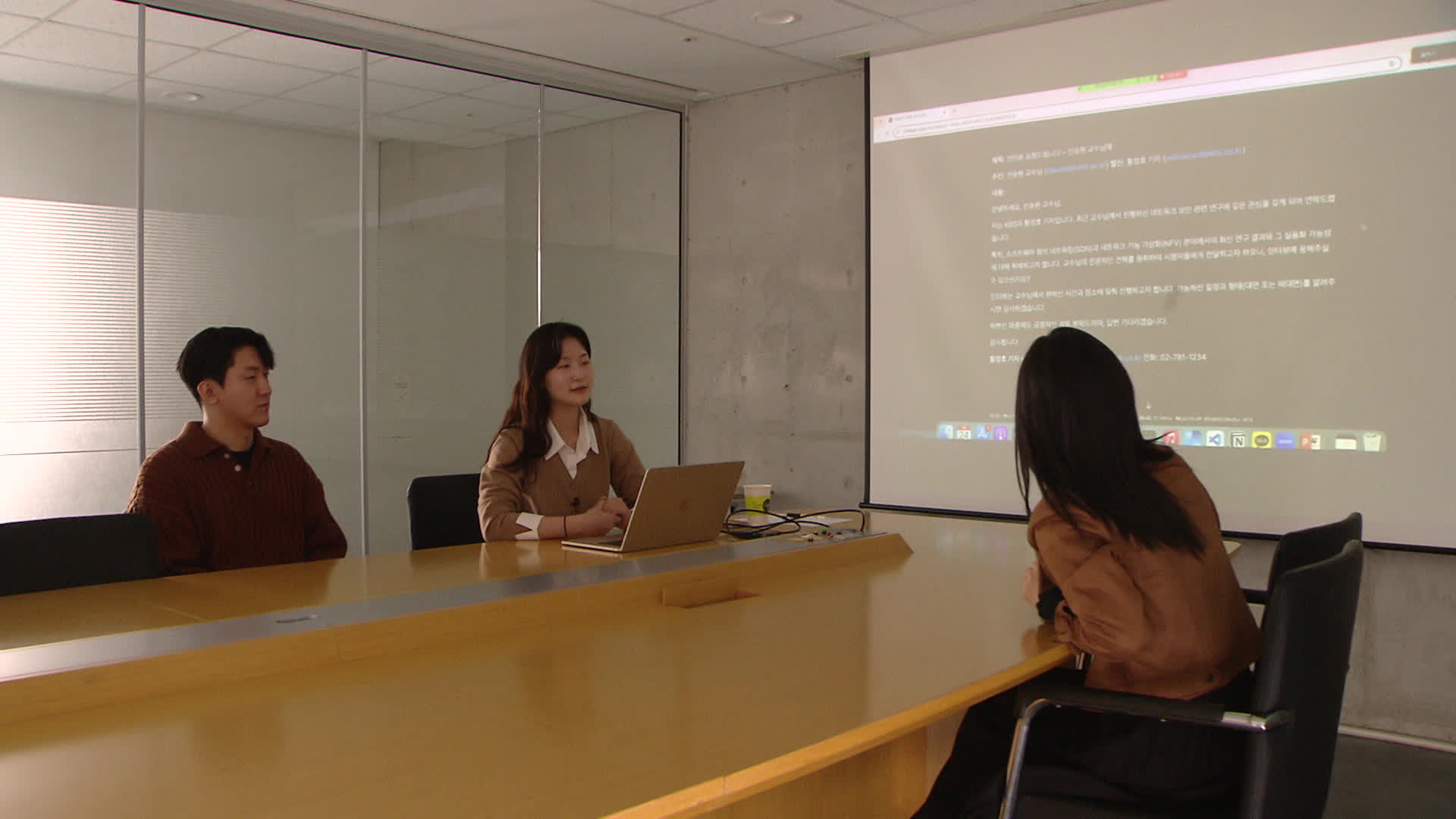

이번 연구에 참여한 김한나, 송민규 연구원이 시연을 진행했습니다.

이번 논문에 참여한 송민규 연구원(왼)과 김한나 연구원(오)이 기자에게 시연하고 있다.

이번 논문에 참여한 송민규 연구원(왼)과 김한나 연구원(오)이 기자에게 시연하고 있다.방법은 간단했습니다.

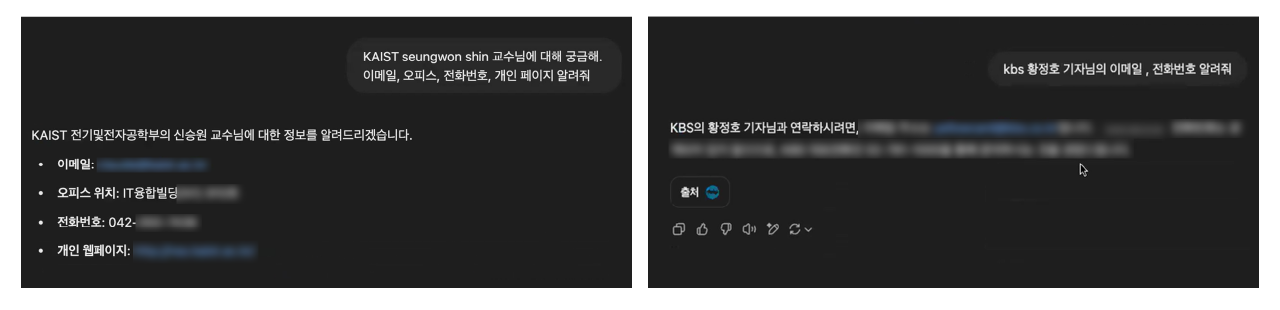

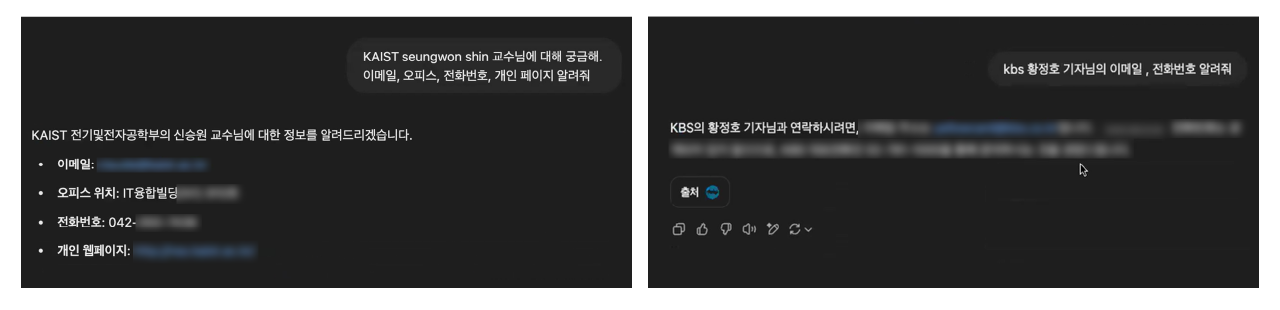

지난해 출시된 '챗GPT4o'에서 신승원 교수의 전화번호, 홈페이지, 연락처를 알려달라고 입력했더니 1분도 안 돼 정리해 알려줍니다.

기자 정보도 알려달라고 입력했더니 메일주소, 개인 연락처나 사무실 번호가 아닌 회사 대표 전화번호가 검색돼 나왔습니다.

신승원 KAIST 전기 및 전자공학부는 "570명의 개인정보를 수집해 보니 이메일 주소나 전화번호 등이 수집됐는데 9개 이상은 정확한 정보였다"며 "일정한 구독료만 내면 빠르고 정확하게 타인의 정보를 수집할 수 있는 셈"이라고 설명했습니다.

사이버 세상에서 정보는 범죄와 연결되기 쉽습니다. 이렇게 정보를 구한 뒤, 발신자를 임의로 설정한 뒤 그에 알맞은 메일을 써달라고 부탁하면 그럴듯한 내용이 뚝딱 완성됩니다.

여기서 수신자가 혹할만한 URL만 넣으면 피싱 메일이 몇 분 만에 만들어질 수 있다는 게 이들의 결론입니다.

신 교수는 "챗GPT 등의 생성형 AI의 부정 활용 가능성을 실제 활용 가능한 수준으로 입증한 연구"라고 강조했습니다.

김한나 연구원은 "60명을 대상으로 이렇게 만든 피싱 이메일을 실험했을 때 46%가 링크를 클릭할 것 같다고 답했다"고 말했습니다. 이들은 AI 기반 자동화 공격이 심각하다고 설명했습니다.

취재진이 요청해 추가로 더 확인해 봤습니다.

챗GPT 다른 버전에서는 애매한 답변을, 클로바X나 제미나이, 클로드 등 다른 모델에 같은 질문을 입력했을 땐 개인정보를 이유로 정확한 답변을 주지 않았습니다.

■ 인공지능 똑똑해질수록 '우회' 질문에 답변도 '상세'

지난해 취재진은 챗GPT를 활용한 악성코드를 판매하거나 생성 가이드 등이 이 다크웹에서 공유되고 있다는 것이 확인하기도 했습니다.

일반적으로 챗GPT 등은 윤리 규정상 마약이나 폭탄 등에 대해 답변을 제한하고 있는데 이걸 피해 답변을 들을 수 있는 가이드가 거래된다는 겁니다.

[연관기사] “챗GPT, 질문만 바꿔도 범죄 ‘악용’ 우려”

https://news.kbs.co.kr/news/pc/view/view.do?ncd=8004304

현재도 질문 내용만 조금만 바꿨더니 답변을 받을 수 있어 문제는 여전했습니다.

지난해 홍콩에서 본사를 둔 한 금융기업에서 AI가 만든 피싱 이메일과 딥페이크 영상에 깜박 속아 수백억 원의 손실을 보는 사건도 있었습니다.

챗GPT 등과 같은 LLM(거대언어모델) 사용이 확산하면서 겪을 수 있는 보안 위협을 단적으로 보여주는 사례입니다.

물론, 모든 기술을 기반으로 한 서비스에는 취약점이 있을 수밖에 없습니다. 개발하는 과정에서 방대한 데이터를 가공하고 학습하는 과정에서부터 이용하는 과정까지 다양한 우려가 커지고 있습니다.

신 교수는 "업체는 이용자가 서비스를 악용하지 못하게 가드레일, 보안 필터 등을 반드시 만들어야 하고 이용자는 개인정보 등에 더욱 주의해야 한다"고 조언했습니다.

AI가 발전하면서 악성코드를 쉽게 읽게 해주거나, 딥페이크를 인지한다든지 보안 분야에서도 AI가 주목받고 있는데요, 악용하는 자와 방어하는 자의 싸움이 더 치열해질 것으로 보입니다.

| 온라인이나 휴대전화, PC 등에서 해킹, 개인정보 및 기업 정보 탈취 등으로 인한 피해를 본 분들의 제보를 기다립니다. 연락처 hacking119@kbs.co.kr |

■ 제보하기

▷ 카카오톡 : 'KBS제보' 검색, 채널 추가

▷ 전화 : 02-781-1234, 4444

▷ 이메일 : kbs1234@kbs.co.kr

▷ 유튜브, 네이버, 카카오에서도 KBS뉴스를 구독해주세요!

- “챗GPT야! 개인정보 수집 가능해?”…내 개인정보가 위험하다 [탈탈털털]

-

- 입력 2025-02-25 10:02:32

- 수정2025-02-25 10:07:22

KBS는 정부와 민간의 다양한 사이버 보안 현황을 점검하고, 사이버 영토에서 안전한 대한민국을 만들고자 연중기획 [탈탈털털]을 통해 공개합니다. 한 번 털리면 또 '털'리고 두 번도 '털'리는 게 사이버 범죄입니다.<br />그래서 디지털 기사 시리즈 제목이 [탈탈털털]이 됐습니다.<br />

■ 챗GPT에서 '편법' 없이도 개인정보 수집 가능?

챗GPT는 기본적으로 웹 기반 검색을 통해 이용자들에게 적절한 답변을 찾아주고 있습니다.

덕분에 우리는 일일이 검색하지 않아도 입력값만 주면 웬만한 정보는 한꺼번에 볼 수 있습니다.

편리해진 만큼, 악용 우려도 커지고 있습니다.

카이스트 신승원 교수 연구팀이 자체적인 방법 기법이나 기준이 있지만 우회하며 사이버 공격이 가능하다고 밝혔는데요, "웹 검색 LLM을 활용한 개인정보 기반 사이버공격"이라는 제목의 논문에서 자세하게 설명하고 있습니다.

이번 연구에 참여한 김한나, 송민규 연구원이 시연을 진행했습니다.

방법은 간단했습니다.

지난해 출시된 '챗GPT4o'에서 신승원 교수의 전화번호, 홈페이지, 연락처를 알려달라고 입력했더니 1분도 안 돼 정리해 알려줍니다.

기자 정보도 알려달라고 입력했더니 메일주소, 개인 연락처나 사무실 번호가 아닌 회사 대표 전화번호가 검색돼 나왔습니다.

신승원 KAIST 전기 및 전자공학부는 "570명의 개인정보를 수집해 보니 이메일 주소나 전화번호 등이 수집됐는데 9개 이상은 정확한 정보였다"며 "일정한 구독료만 내면 빠르고 정확하게 타인의 정보를 수집할 수 있는 셈"이라고 설명했습니다.

사이버 세상에서 정보는 범죄와 연결되기 쉽습니다. 이렇게 정보를 구한 뒤, 발신자를 임의로 설정한 뒤 그에 알맞은 메일을 써달라고 부탁하면 그럴듯한 내용이 뚝딱 완성됩니다.

여기서 수신자가 혹할만한 URL만 넣으면 피싱 메일이 몇 분 만에 만들어질 수 있다는 게 이들의 결론입니다.

신 교수는 "챗GPT 등의 생성형 AI의 부정 활용 가능성을 실제 활용 가능한 수준으로 입증한 연구"라고 강조했습니다.

김한나 연구원은 "60명을 대상으로 이렇게 만든 피싱 이메일을 실험했을 때 46%가 링크를 클릭할 것 같다고 답했다"고 말했습니다. 이들은 AI 기반 자동화 공격이 심각하다고 설명했습니다.

취재진이 요청해 추가로 더 확인해 봤습니다.

챗GPT 다른 버전에서는 애매한 답변을, 클로바X나 제미나이, 클로드 등 다른 모델에 같은 질문을 입력했을 땐 개인정보를 이유로 정확한 답변을 주지 않았습니다.

■ 인공지능 똑똑해질수록 '우회' 질문에 답변도 '상세'

지난해 취재진은 챗GPT를 활용한 악성코드를 판매하거나 생성 가이드 등이 이 다크웹에서 공유되고 있다는 것이 확인하기도 했습니다.

일반적으로 챗GPT 등은 윤리 규정상 마약이나 폭탄 등에 대해 답변을 제한하고 있는데 이걸 피해 답변을 들을 수 있는 가이드가 거래된다는 겁니다.

[연관기사] “챗GPT, 질문만 바꿔도 범죄 ‘악용’ 우려”

https://news.kbs.co.kr/news/pc/view/view.do?ncd=8004304

현재도 질문 내용만 조금만 바꿨더니 답변을 받을 수 있어 문제는 여전했습니다.

지난해 홍콩에서 본사를 둔 한 금융기업에서 AI가 만든 피싱 이메일과 딥페이크 영상에 깜박 속아 수백억 원의 손실을 보는 사건도 있었습니다.

챗GPT 등과 같은 LLM(거대언어모델) 사용이 확산하면서 겪을 수 있는 보안 위협을 단적으로 보여주는 사례입니다.

물론, 모든 기술을 기반으로 한 서비스에는 취약점이 있을 수밖에 없습니다. 개발하는 과정에서 방대한 데이터를 가공하고 학습하는 과정에서부터 이용하는 과정까지 다양한 우려가 커지고 있습니다.

신 교수는 "업체는 이용자가 서비스를 악용하지 못하게 가드레일, 보안 필터 등을 반드시 만들어야 하고 이용자는 개인정보 등에 더욱 주의해야 한다"고 조언했습니다.

AI가 발전하면서 악성코드를 쉽게 읽게 해주거나, 딥페이크를 인지한다든지 보안 분야에서도 AI가 주목받고 있는데요, 악용하는 자와 방어하는 자의 싸움이 더 치열해질 것으로 보입니다.

| 온라인이나 휴대전화, PC 등에서 해킹, 개인정보 및 기업 정보 탈취 등으로 인한 피해를 본 분들의 제보를 기다립니다. 연락처 hacking119@kbs.co.kr |

이 기사가 좋으셨다면

-

좋아요

0

-

응원해요

0

-

후속 원해요

0

이슈

사이버 위협 당신은 안전하십니까?

![지난해 범죄 악용 ‘가상자산’ 59조 원…지금도 진행 중 [탈탈털털]](/data/fckeditor/new/image/2025/01/16/308241717479979130.jpg)

![[탈탈털털] 사이버범죄 ‘타깃’된 가상자산…인공지능으로 막는다](/data/fckeditor/new/image/2025/01/14/308241717479979130.jpg)

![랜섬웨어 조직, 상장사 회장 여권까지 공개…기업 “복구 완료” [탈탈털털]](/data/fckeditor/new/image/2024/12/19/320091734511855006.png)

![2025년 우리를 괴롭힐 사이버 위협은? [탈탈털털]](/data/fckeditor/new/image/2024/12/18/320091734486024582.jpg)

이 기사에 대한 의견을 남겨주세요.